深度卷积神经网络与相位解缠-袁志辉博士

2021-04-07

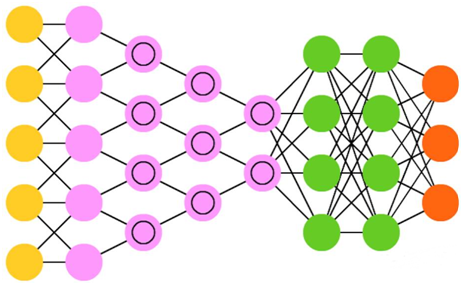

神经网络技术起源于上世纪五、六十年代,当时叫感知机(perceptron),由输入层、隐藏层和输出层三部分组成,这三部分各占一层。而卷积神经网络(Convolutional Neural Network, CNN)又简称卷积网络,是一种用来处理网格状结构数据的特殊网络结构,其基本结构如图1所示。简单来说,只要是包含卷积层的神经网络我们就可以称之为卷积神经网络。它主要用于图像处理,也可应用于音频等其它类型的输入信号。

图1 深度卷积神经网络的基本结构

1962年,受对猫的视觉皮层细胞研究的启发,科学家提出了感受野(Receptive Field)的概念。1982年,Fukushima在感受野概念的基础上提出了CNN的第一个实现版本—神经认知机(Neocognitron)。神经认知机将一个视觉特征分解为多个子特征,通过层层分解与组合将视觉系统模型化,使其能够在物体有位移或轻微形变的时候,也能正确进行识别。1989年,Y.LeCun等人提出了一个五层的卷积神经网络LeNet,完美解决了手写数字的识别问题,可以算是CNN由理论走向实际应用的一个开端,但是由于当时训练样本的匮乏和计算能力的不足,CNN并没有流行起来,反而是支持向量机等手工设计特征的方法成为主流。沉寂多年后,随着大数据时代的来临、CNN本身的不断改进(ReLU激活函数取代Sigmoid函数,Dropout思想的提出)以及以GPU为主的并行计算的盛行,CNN开始逐渐发展起来。到了2012年,AlexKrizhevsky等人利用一个八层的卷积神经网络AlexNet在当年的ImageNet图像分类竞赛中取得了冠军,并远超第二名十个百分点,让CNN再次回到了大众的视野。随后各种改进的卷积神经网络结构如雨后春笋般涌现出来,其中比较有代表性的是VGG、GoogleNet和ResNet。

CNN的在真实世界实现时往往会在末端连接一个前向传播网络(Feed-forward Neural Networks, FFNN)以便进一步处理数据,从而可以实现高度非线性抽象。此时,我们把这样的网络称为深度卷积神经网络(Deep Convolutional Neural Network, DCNN),其实就是隐藏层大于2层的卷积神经网络,这使得它具有更深的抽象能力和降维能力。实际上,CNN和DCNN的名字和缩写往往可以混用。另外,“卷积”和“深度”是神经网络互相独立的两个性质,其中“卷积”是指网络前端有卷积层,而“深度”是指网络的层数有很多(从理论上来说有两个隐藏层就可以叫“深度”了)。

合成孔径雷达(SAR)技术是一种对地面进行主动观测的遥感技术,InSAR技术则是在合成孔径雷达技术基础上融合干涉测量技术的一种新型遥感技术。InSAR系统利用搭载在平台上的SAR天线,对同一区域进行单次或多次重轨观测,以获得同一景区的两幅单视复数(SLC)图像。对这两幅SLC图像进行配准后再复共轭相乘,并取其缠绕相位值(-π到π之间)便可得到干涉图。干涉图对应的绝对相位差反映了目标地物与天线相位中心之间的几何关系,可以用来反演目标地物的高程信息。而要想得到这样的绝对干涉相位,便需要用到相位解缠技术。该技术是InSAR诸多处理步骤中最困难、也最容易失败的一个步骤。传统的InSAR相位解缠技术需要基于相位连续性假设来估算图像的真实相位信息。所谓相位连续性假设是指相邻像素间绝对干涉相位的变化不超过π。然而,这样的假设条件在地形起伏较大的地区并不满足,例如高海拔山区、地震震中、城市高楼、跨海大桥等区域。另外,随着InSAR技术的迅速发展,干涉图(或称为缠绕相位图)的尺寸变得越来越大,可以说InSAR技术已经进入大数据时代。此时如果还是利用传统的相位解缠算法进行相位解缠,则需要消耗大量的内存与运算时间才能得到高质量的相位解缠结果。而如果将深度学习技术应用到InSAR数据处理中,将深度卷积神经网络引入到相位解缠技术中来的话,那么前面所说的问题都能够迎刃而解。当然,目前似乎还没有多少研究使用深度学习方法来分析干涉图或支持InSAR处理,使用该技术还需要进行科学的深度学习机理模型设计,即需要对技术系统参数和观测对象机理特征进行一个科学的学习过程。一个比较直观的思路便是从已知数据的物理计算模式积累的数据计算经验去建立自己的模型,从而进一步补充物理算法。总之,从技术角度可以预见,InSAR处理采用人工智能(AI)将会定义一个崭新的InSAR时代。