车联网的移动边缘智能与计算-张鑫博士

2022-01-18

车联网 (Internet of Vehicles,IoV)是一种新兴范式,由车辆通信和网络的最新发展推动(图1)。汽车的性能和智能正在迅速增强,将有可能支持大量令人兴奋的新应用,集成全自动驾驶汽车、物联网(Internet of Things,IoT)和环境。这些趋势将带来智能车联网时代,同时,这将严重依赖于通信、计算和数据分析技术。对于智能车产生的海量数据,由于资源/功率的限制和通信开销/延迟的限制,车载处理和云计算是不够的。通过在无线网络边缘(如无线接入点)部署存储和计算资源,包括边缘缓存、边缘计算和边缘人工智能的边缘信息系统(Edge Information System,EIS)将在未来的智能车联网中发挥关键作用。EIS不仅将提供低延迟的内容交付和计算服务,而且还将提供本地化的数据采集、聚合和处理。

图1 车联网的一些概念图

1. 引言

一个多世纪以来,汽车工业一直是主要的经济部门之一,其经济和社会影响不断扩大。信息和通信技术被认为是革新车辆网络的有前途的工具。车联网将具备通信、处理、存储和学习能力。特别是,有了车联网,车辆将能够利用云存储和计算等资源。除了车辆行驶和安全外,车联网还将为城市交通管理、车辆保险、道路基础设施建设和维修、物流运输等提供便利。作为物联网的特殊情况,车联网需要与智能城市等其他系统进行集成。

由于嵌入式系统、导航、传感器、数据采集和传播以及大数据分析等方面的最新进展,我们正见证着汽车的日益智能化[1][2]。它始于辅助驾驶技术,即高级驾驶员辅助系统(advanced driver assistance systems,ADAS),包括紧急制动、倒车摄像头、自适应巡航控制和自动停车系统[3]。在全球范围内,ADAS系统的数量从2014年的9000万台增长到2016年的约1.4亿台,在短短两年的时间里增长了50% [4]。根据国际汽车工程师学会(Society of Automotive Engineers International,SAE)对自动驾驶汽车的定义,上述系统主要属于自动化的1级和2级。特斯拉的自动驾驶系统也属于该类[5]。2018年的奥迪A8是第一辆已投产的3级自动驾驶汽车[6]。预测各不相同,但许多人预测,4级和5级自动驾驶汽车将在10年内上市。

即将到来的智能车联网将需要各个领域的支持,包括汽车、交通、无线通信、网络、安全和机器人,以及监管机构和政策制定者。本文将从信息和通信技术的角度对智能车进行研究。特别是,在无线网络边缘(如无线电接入点)集成存储、通信、计算和数据分析,为解决智能车联网的数据采集、聚合和处理挑战提供一个有效的框架。接下来,阐述智能车联网面临的大数据挑战及其激发的对边缘信息系统EIS的需求。

信息技术的进步,包括通信、传感、数据处理和控制,正在将交通系统从传统的技术驱动系统转变为更强大的数据驱动的智能交通系统[7]。这种流行的运动将产生大量的数据。在过去的20年里,无线行业一直在努力应对智能手机带来的移动数据爆炸[8]。然而,与智能车预计将产生的海量数据相比,这样的竞争将会相形见绌。智能车辆配备了多个摄像头和传感器,包括雷达、激光雷达(light detection and ranging,LiDAR)传感器、声纳和全球导航卫星系统(global navigation satellite systems,GNSS)。预计未来单辆车将有超过200个传感器[9],传感器总带宽将达到3Gb/s (1.4TB/h)至40Gb/s (19TB/h)[10]。据英特尔估计,每辆自动驾驶汽车每天将产生大约4000GB的数据,相当于近3000人的移动数据。假设全球只有100万辆自动驾驶汽车,那么自动驾驶就相当于30亿人的数据。英特尔首席执行官布莱恩•科再奇(Brian Krzanich)表示:“数据是自动驾驶未来的新石油”[11] 。

智能车联网产生的大数据将给通信、存储和计算基础设施带来前所未有的压力。虽然车载计算和存储能力正在迅速增长,但与存储和处理的数据规模相比,它们仍然有限。例如,NVIDIA的自动驾驶学习数据采集系统采用了固态硬盘(solid-state drive,SSD)作为外部存储器,最多可存储数TB的数据,在数小时内就可以被感知数据填满。此外,处理这些数据所需的计算很容易耗尽车载计算资源。配备10个高分辨率摄像头的汽车可以产生2Gpixels/s的数据。通过多个深度神经网络(deep neural networks,DNNs)处理这么多数据,可转换为大约每秒250万亿次操作(TOPS)[12]。与此同时,为了实现比最佳人类驾驶员在100~150ms内采取行动的更高的安全性,自动驾驶系统必须能够在100ms的延迟内处理实时交通状况[13],这需要大量的计算能力。图形处理单元(graphics processing units, GPU)等耗电量大的加速器可以提供低延迟计算,但它们的高功耗,进一步被满足热约束的冷却负载放大,会显著降低车辆的行驶里程和燃油效率[13]。

关于使用云计算[14]来帮助智能车辆的建议有很多,其中一些已经实现了,比如基于云的软件更新或训练强大的深度学习模型[15]。云计算平台当然是车联网的重要支持者,但它们还不够。成本和功耗是车载计算的主要限制因素,而长延时和海量数据传输是云处理的瓶颈[16]。从移动客户端到云中心的往返时间可能很容易超过100ms[17]。而且这种延迟很大程度上取决于无线信道条件、网络带宽和流量拥塞,无法保证实时处理和可靠性。如[17]所示,考虑到延迟需求,如果要卸载辅助驾驶系统的语音识别任务,服务器必须位于附近的基站(base station, BS),即无线网络的边缘。这与最近将计算资源部署在无线网络边缘的趋势是一致的[18]-[21]。

1.2 边缘资源部署

为了克服车载计算、通信、存储和能量的限制,同时避免云计算的过度延迟,在无线网络边缘部署资源受到了学术界和业界的广泛关注。在移动数据流量中占据主导地位的视频文件等热门内容,很可能会被不同的用户反复请求,这种请求是可以预测的。因此,在无线网络边缘部署存储单元并缓存流行内容,即无线边缘缓存,是一种很有前途的高效内容交付解决方案[22]–[24]。同时,人工智能(artificial intelligence,AI)的复兴和智能移动应用的出现,需要能够支持计算密集型和延迟敏感的移动计算的平台。移动边缘计算(mobile edge computing,MEC)是一种新兴技术,它有潜力将电信与云计算结合起来,直接从网络边缘提供云服务,并支持关键延迟的移动应用。这是通过将计算机服务器放置在BSs或无线电接入点来实现的[18]-[21],[25]。边缘缓存和计算平台进一步实现了边缘AI,它在边缘服务器和移动设备上训练和部署强大的机器学习模型,并被视为物联网的关键支持技术[26][27]。边缘AI正在改变半导体产业的格局。2018年,边缘AI的出货量收入达到13亿美元,到2023年,这一数字预计将达到230亿美元[28]。在本文中,这些平台统称为EIS。

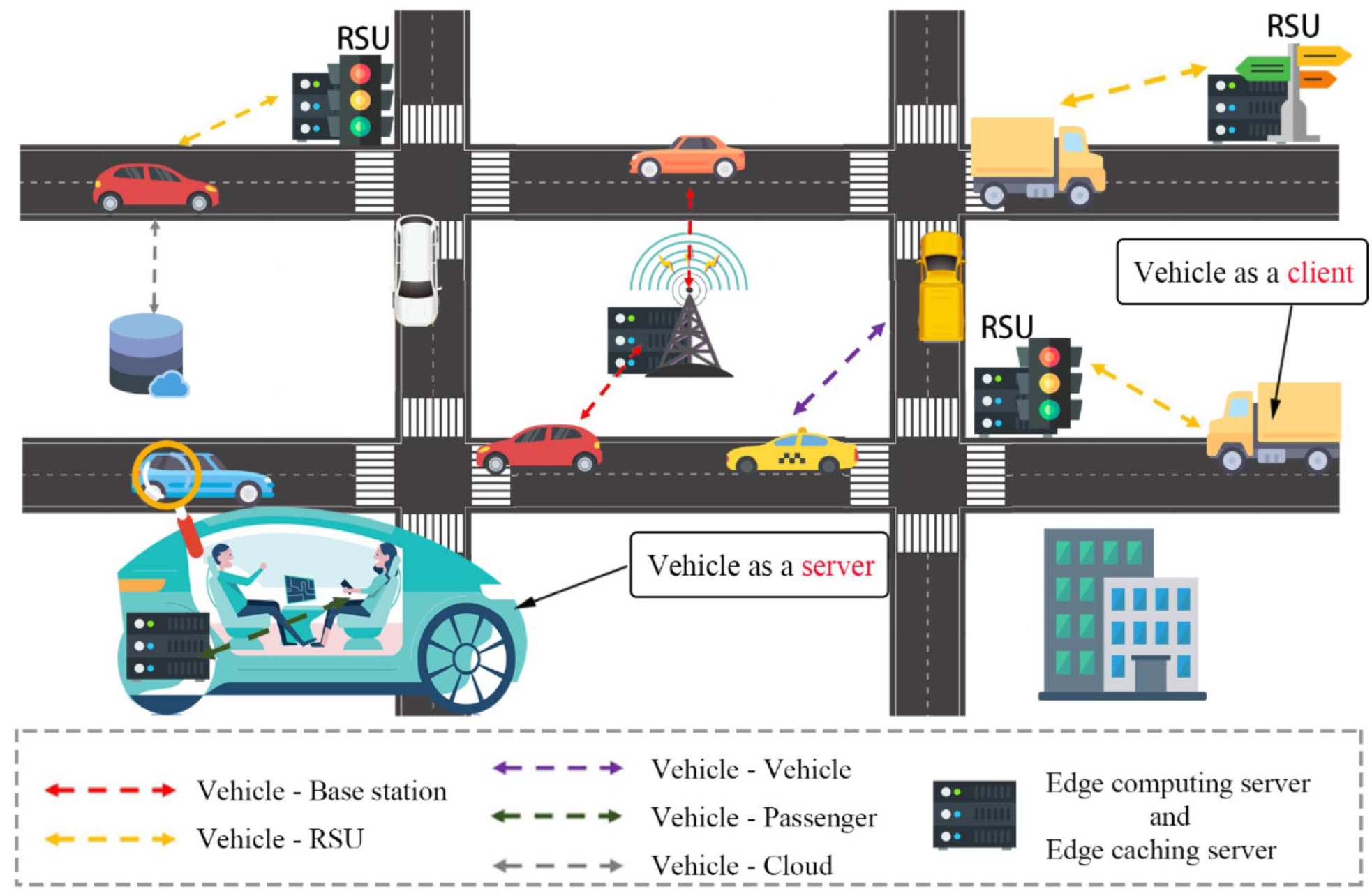

EIS非常适合智能车联网。它能够辅助智能车辆的关键功能,从数据采集(用于态势和环境感知),数据处理(用于导航和路径规划),到驱动(机动控制),如图2所示。在网络边缘处理数据可以节省大量的通信带宽,也可以满足对关键任务的低延迟要求。车联网的内容通常具有较高的空间局部性,如路况和地图信息主要用于局部,而时间局部性,如上午的交通状况与晚上的关系不大。此外,车辆只对内容本身感兴趣,而不是其来源。这些关键特性使得IoV的缓存辅助内容中心传播和交付非常有效[29][30]。另一方面,智能车辆由于具有大的传感数据,面临着巨大的计算负担。例如,计算能力仍然是阻碍车辆从高分辨率摄像机带来的高系统精度中获益的瓶颈。其中,功能强大的卷积神经网络(CNN)[31]中用于视觉感知的卷积任务和用于视觉定位的特征提取任务是高度复杂的[32]。将这些计算密集型任务转移到邻近的MEC服务器,将使强大的机器学习方法能够协助智能车辆[33]的关键任务。

智能车联网需要利用不同的信息处理平台。

1) 车载处理用于高延迟敏感的任务,如车辆控制的实时决策,并对传感数据进行预处理,以减少通信带宽。

2) 边缘服务器适用于定位、地图绘制等对延迟敏感、计算量大的任务,也适用于聚集和存储地区高清地图等本地信息。

3) 云计算是为了用大量的数据集训练强大的深度学习模型,作为广域信息的非实时聚合器,并存储有价值的历史数据以供持续学习。

EIS将在智能车信息基础设施中发挥重要而独特的作用。通过全面、深入地引入智能车车载EIS有望填补这一空白。

图2 EIS支持的智能车联网

2. 车联网的边缘信息系统

EIS帮助智能车辆获取、聚合和处理数据。在车联网中,它充当车载处理器和远程云数据中心之间的中介平台。如图2所示,EIS主要包括以下几个部分。(1)边缘服务器:部署在BSs或路边单元(roadside units,RSUs)的计算机服务器,配备存储单元(如SSD)和计算单元,如GPU或边缘张量处理单元(TPU)[34]。(2)车辆:智能车辆配备各种传感器、通信模块和具有计算和存储能力的车载单元,智能汽车是强大节点[35]。(3)用户设备:用户设备种类繁多,如乘客智能手机、可穿戴设备等。(4)V2X通信:通信模块是EIS的重要组成部分。

后续本文根据车辆的角色考虑两种不同的场景,车辆作为客户端(VaaC)和车辆作为服务器(VaaS)。(1)VaaC:首先,车辆可以作为客户端访问RSUs或BSs的边缘资源。其关键思想是将数据采集和处理并行进行。边缘服务器充当数据采集的锚节点,然后为本地应用程序处理数据。例如,他们可以从经过的车辆中收集地图数据,建立和更新高清地图,并可以主动监测当地的道路状况和交通状况。这些应用与车联网高度相关。(2)VaaS:车辆还可以作为车辆乘客、第三方接受者和其他车辆的移动服务提供商,提高用户体验,如通过驾驶员身份识别实现个性化驾驶体验,以及丰富的信息娱乐应用。与基于边缘服务器的方法相比,VaaS的移动性更小。此外,它还允许相邻车辆之间的协作,如协作感知、协作驾驶等。

2.2智能汽车的关键任务

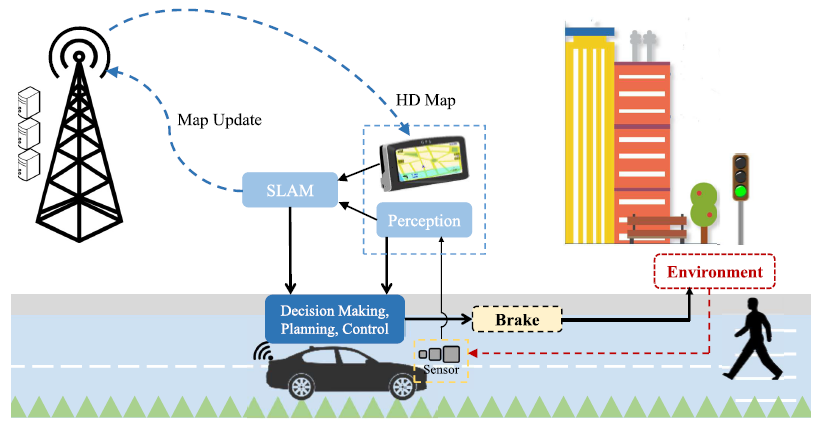

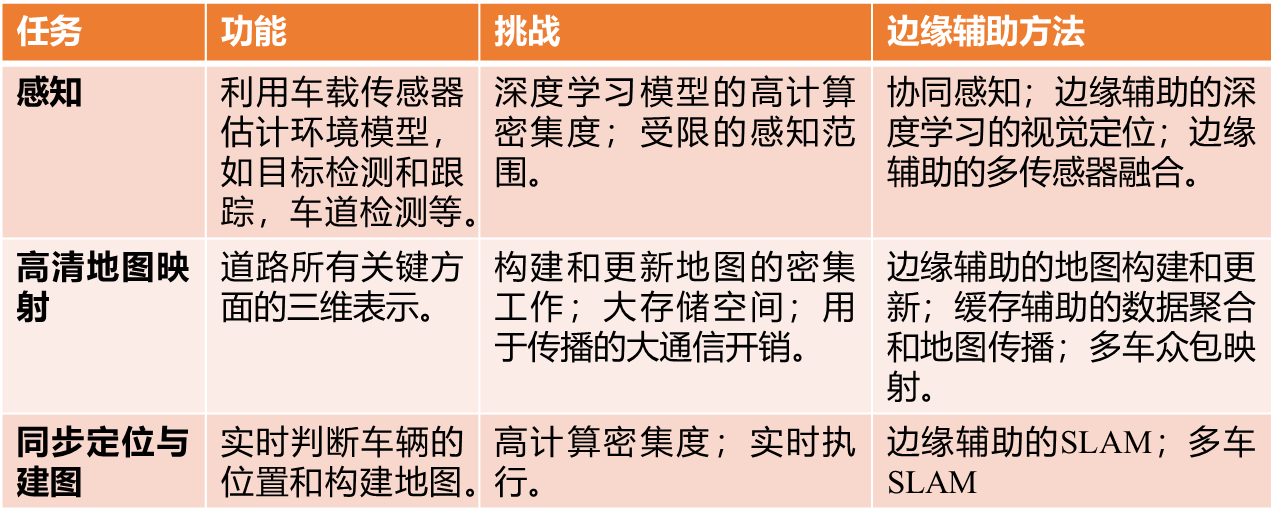

智能车辆的基础是对环境的理解能力。不同的车载传感器用于不同的感知任务,如目标检测/跟踪、交通标志检测/分类、车道检测等。也利用了先验知识,如先验地图。基于传感数据和感知输出,应用定位和映射算法计算车辆的全局和局部位置,绘制环境地图。这些任务的结果然后用于其他功能,包括决策、计划和车辆控制,如图3所示。这里,重点关注感知、高清地图、同步定位与建图(simultaneous localization and mapping,SLAM)作为智能车辆的主要任务,如表1所示。

图3 智能车辆的关键任务,以及它们如何在自动驾驶中协同行动

(1)感知

有各种各样的车载传感器,具有不同的特点,服务于不同的感知任务。每种传感器都有其局限性。与主动传感器(如激光雷达和雷达)相比,相机和立体视觉在计算上是昂贵的,而激光雷达和雷达在分类和非常近(<2m);而声纳的角度分辨率很差。智能汽车的感知面临一些主要挑战,如恶劣天气和光照条件下的感知,或复杂的城市环境下的感知,以及有限的感知范围。通过利用不同传感器的传感数据,可以利用传感器融合等技术来弥补单个传感器的不足[36][37]。然而,这将显著增加机载计算。通过提供额外的近似计算和存储资源,EIS能够提高感知能力。它可以帮助提高相机和立体视觉的传感精度,例如,通过强大的深度学习技术,并通过将计算密集型子任务转移到边缘服务器,实现复杂的多传感器融合。此外,协同感知通过共享板载感知能力和计算能力,以V2V和V2I通信为辅助,并通过边缘服务器进行协调,可显著提高感知鲁棒性和准确性,扩展感知范围[38]。

表1 智能汽车的关键任务

(2)高清地图

地图是任何移动机器人应用的基础,它对自动驾驶尤为重要。高清地图模拟路面的精度为10-20cm。它包含道路所有关键方面的三维表示,例如,坡度和曲率,车道标记类型和路边物体。高清地图定位可以达到厘米级的精度。它利用车载传感器,将车辆感知的环境与相应的高清地图进行比较。这可以克服基于GNSS的方法(如GPS)定位精度低、可用性变化等局限性。预计,基于高清地图的本地化将成为4级和5级自动驾驶系统的通用方法。在制作高清地图方面,业界已经做出了很大的努力[39][40]。然而,在实际执行方面存在困难。制作高清地图非常耗时。为生成高清地图,需要配备专门映射移动映射系统(mobile mapping system,MMS) 的车辆,整个过程包括三个步骤:数据采集用于获取测绘数据,数据积累用于积累测绘车辆采集的特征,数据确认用于手动细化和确认地图。而且高清地图是动态的,需要及时更新的变化[41]。一些高清地图供应商与汽车制造商合作,从智能汽车上获取最新的地图数据,但这将大大增加车辆的车载处理负担[42]。

由于高清地图数据精度高,且具有丰富的几何信息和语义,因此高清地图数据的尺寸非常大[43],造成了传输和存储高清地图的困难。它们通常是由云服务提供的,地图附近的一些小区域会下载到车辆上。一份厘米级精度的3D高清地图需要下载的数据量可以达到3-4Gb/km。这不仅给从云上下载数据带来了延迟,也给骨干网带来了沉重的负担。由于其固有的地理局部性,EIS将在智能车高清制图中发挥重要作用。可以采用不同的边缘辅助方法。边缘缓存可以帮助高清地图传播和地图数据聚合。通过利用本地缓存的数据,边缘计算可以帮助地图构建和地图变化检测。边缘服务器还可以协调车辆通过该区域进行众包绘图。这样,通过在本地保存和处理数据,并在需要的地方构造地图,可以实现更高效的高清制图。

(3)同步定位与建图

基于地图的定位对于在不经常变化的道路上行驶是有效的。然而,如果发生剧烈的变化,准确性的损失可能会影响驾驶安全。SLAM包括同时估计车辆状态和构建环境地图[44]-[47]。它不依赖于先验信息,允许车辆持续观察环境,并容易适应新的情况。为了实现完全自主,智能车辆必须能够在其所处的环境中进行准确的SLAM[45]。SLAM被认为是自动驾驶的关键实现技术,2007年DARPA城市挑战赛的车辆已经使用了基于SLAM的方法[48]。虽然已经开发了许多SLAM算法,但它们主要是针对室内、高度结构化的环境。自动驾驶汽车需要在户外、光线多变的道路环境中运行,因此需要更快、更有效的算法。特别是,SLAM对自动驾驶的计算需求将是高度密集的;1小时的驱动时间可以生成1tb的数据,而利用高计算能力对1Tb的收集数据进行解释需要2天的时间才能得到可用的导航数据[42]。此外,对于实时执行,延迟必须低于10ms,这给车载计算带来了很大压力。

虽然基于云的SLAM算法已经被提出以减轻车辆的计算负担,但其传播延迟无法满足实时性的执行要求。边缘计算平台可以解决这一难题,它可以帮助处理部分计算密集型子例程[49]。多车SLAM,车辆间的合作也有助于提高SLAM的性能[47]。

参考目录:

[1] J. Levinson et al., “Towards fully autonomous driving: Systems and algorithms,” in Proc. IEEE Intell. Vehicles Symp., Jun. 2011, pp. 163–168.

[2] T. Luettel, M. Himmelsbach, and H.-J. Wuensche, “Autonomous ground vehicles—Concepts and a path to the future,” Proc. IEEE, vol. 100, Special Centennial Issue, pp. 1831–1839, May 2012.

[3] K. Bengler, K. Dietmayer, B. Farber, M. Maurer, C. Stiller, and H. Winner, “Three decades of driver assistance systems: Review and future perspectives,” IEEE Intell. Transp. Syst. Mag., vol. 6, no. 4, pp. 6–22, Oct. 2014.

[4] K. Heineke, P. Kampshoff, A. Mkrtchyan, and E. Shao, “Self-driving car technology: When will the robots hit the road?” McKinsey, New York, NY, USA, Tech. Rep., May 2017.

[5] Tesla. (2019). Tesla Autopilot: Full Self-Driving Hardware on All Cars. [Online]. Available: https://www.tesla.com/autopilot

[6] C. Gauthier, “The 2018 Audi A8 is the first Level 3 self driving car,” Autonation Drive, Aug. 2017. [Online]. Available: https://autonationdrive.com/ 2018-audi-a8-first-level-3-self-driving-car/

[7] J. Zhang, F.-Y. Wang, K. Wang, W.-H. Lin, X. Xu, and C. Chen, “Data-driven intelligent transportation systems: A survey,” IEEE Trans. Intell. Transp. Syst., vol. 12, no. 4, pp. 1624–1639, Dec. 2011.

[8] J. G. Andrews et al., “What will 5G be?” IEEE J. Sel. Areas Commun., vol. 32, no. 6, pp. 1065–1082, Jun. 2014.

[9] (2017). Automotive Sensors and Electronics Expo 2017. [Online]. Available: http://www.automotivesensors2017.com/

[10] S. Heinrich, “Flash memory in the emerging age of autonomy,” in Proc. Flash Memory Summit, Santa Clara, CA, USA, Aug. 2017, pp. 1–10.

[11] B. Krzanich. (2016). Data is the new oil in the future of automated driving. Intel. [Online]. Available: https://newsroom.intel.com/editorials/krzanich-the-future-of-automateddriving/

[12] Self Driving Safety Report, Nvidia, Santa Clara, CA, USA, 2018.

[13] S.-C. Lin et al., “The architectural implications of autonomous driving: Constraints and acceleration,” in Proc. 23rd ACM ASPLOS, Williamsburg, VA, USA, Mar. 2018, pp. 751–766.

[14] Q. Zhang, L. Cheng, and R. Boutaba, “Cloud computing: State-of-the-art and research challenges,” J. Internet Services Appl., vol. 1, no. 1, pp. 7–18, May 2010.

[15] B. Kehoe, S. Patil, P. Abbeel, and K. Goldberg, “A survey of research on cloud robotics and automation,” IEEE Trans. Autom. Sci. Eng., vol. 12, no. 2, pp. 398–409, 2015.

[16] Q. Zhang et al., “OpenVDAP: An open vehicular data analytics platform for CAVs,” in Proc. IEEE Int. Conf. Distrib. Comput. Syst. (ICDCS), Vienna, Austria, Jul. 2018, pp. 1–11.

[17] A. Cartas et al., “A reality check on inference at mobile networks edge,” in Proc. EdgeSys, Dresden, Germany, Mar. 2019, pp. 54–59.

[18] Y. C. Hu,M. Patel, D. Sabella, N. Sprecher, and V. Young, “Mobile edge computing—A key technology towards 5G,” ETSI, Sophia Antipolis, France, White Paper 11, Sep. 2015, pp. 1–16.

[19] W. Shi, J. Cao, Q. Zhang, Y. Li, and L. Xu, “Edge computing: Vision and challenges,” IEEE Internet Things J., vol. 3, no. 5, pp. 637–646, Oct. 2016.

[20] P. Mach and Z. Becvar, “Mobile edge computing: A survey on architecture and computation offloading,” IEEE Commun. Surveys Tuts., vol. 19, no. 3, pp. 1628–1656, 3rd Quart., 2017.

[21] Y. Mao, C. You, J. Zhang, K. Huang, and K. B. Letaief, “A survey on mobile edge computing: The communication perspective,” IEEE Commun. Surveys Tuts., vol. 19, no. 4, pp. 2322–2358, 1st Quart., 2017.

[22] K. Shanmugam, N. Golrezaei, A. G. Dimakis, A. F. Molisch, and G. Caire, “FemtoCaching: Wireless content delivery through distributed caching helpers,” IEEE Trans. Inf. Theory, vol. 59, no. 12, pp. 8402–8413, Dec. 2013.

[23] E. Bastug, M. Bennis, andM. Debbah, “Living on the edge: The role of proactive caching in 5G wireless networks,” IEEE Commun. Mag., vol. 52, no. 8, pp. 82–89, Aug. 2014.

[24] M. Ji, G. Caire, and A. F. Molisch, “Fundamental limits of caching in wireless D2D networks,” IEEE Trans. Inf. Theory, vol. 62, no. 2, pp. 849–869, Feb. 2016.

[25] Y. Mao, J. Zhang, Z. Chen, and K. B. Letaief, “Dynamic computation offloading for mobile-edge computing with energy harvesting devices,” IEEE J. Sel. Areas Commun., vol. 34, no. 12, pp. 3590–3605, Dec. 2016.

[26] S. Wang et al., “When edge meets learning: Adaptive control for resource-constrained distributed machine learning,” in Proc. IEEE Int. Conf. Comput. Commun. (INFOCOM), Honolulu, HI, USA, Apr. 2018, pp. 63–71.

[27] Z. Zhou, X. Chen, E. Li, L. Zeng, K. Luo, and J. Zhang, “Edge intelligence: Paving the last mile of artificial intelligence with edge computing,” Proc. IEEE, vol. 107, no. 8, pp. 1738–1762, Aug. 2019.

[28] D. H. Deans. (2019). How ‘AI at the edge’ is creating new semiconductor demand. CloudTech. [Online]. Available: https://www.cloudcomputing-news.net/news/2019/mar/26/ai-at-the-edge-creates-new-semiconductordemand/

[29] M. Amadeo, C. Campolo, and A. Molinaro, “Information-centric networking for connected vehicles: A survey and future perspectives,” IEEE Commun. Mag., vol. 54, no. 2, pp. 98–104, Feb. 2016.

[30] R.W. L. Coutinho, A. Boukerche, and A. A. F. Loureiro, “Design guidelines for information-centric connected and autonomous vehicles,” IEEE Commun. Mag., vol. 56, no. 10, pp. 85–91, Oct. 2018.

[31] Y. LeCun, Y. Bengio, and G. Hinton, “Deep learning,” Nature, vol. 521, pp. 436–444, May 2015.

[32] S. Liu, J. Tang, Z. Zhang, and J.-L. Gaudiot, “Computer architectures for autonomous driving,” Computer, vol. 50, no. 8, pp. 18–25, 2017.

[33] K. Zhang, Y.Mao, S. Leng, Y. He, and Y. Zhang, “Mobile-edge computing for vehicular networks: A promising network paradigm with predictive off-loading,” IEEE Veh. Technol. Mag., vol. 12, no. 2, pp. 36–44, Jun. 2017.

[34] Google. Edge TPU: Google’s Purpose-Built ASIC Designed to Run Inference at the Edge. [Online]. Available: https://cloud.google.com/edge-tpu/

[35] S. Abdelhamid, H. Hassanein, and G. Takahara, “Vehicle as a resource (VaaR),” IEEE Netw., vol. 29, no. 1, pp. 12–17, Jan. 2015.

[36] G. Bresson, M.-C. Rahal, D. Gruyer, M. Revilloud, and Z. Alsayed, “A cooperative fusion architecture for robust localization: Application to autonomous driving,” in Proc. IEEE 19th Int. Conf. Intell. Transp. Syst. (ITSC), Rio de Janeiro, Brazil, Nov. 2016, pp. 859–866.

[37] D. Gruyer, R. Belaroussi, and M. Revilloud, “Accurate lateral positioning from map data and road marking detection,” Expert Syst. Appl., vol. 43, pp. 1–8, Jan. 2016.

[38] S.-W. Kim, W. Liu, M. H. Ang, E. Frazzoli, and D. Rus, “The impact of cooperative perception on decision making and planning of autonomous vehicles,” IEEE Intell. Transp. Syst. Mag., vol. 7, no. 3, pp. 39–50, Jul. 2015.

[39] TomTom. (2017). TomTom HD Map for Autonomous Driving Extends to Japan. [Online]. Available: https://corporate.tomtom.com/newsreleases/news-release-details/tomtom-hd-mapautonomous-driving-extends-japan?releaseid=1045730

[40] (2016). HERE Introduces HD Live Map to Show the Path to Highly Automated Driving. [Online]. Available: https://360.here.com/2016/01/05/here-introduces-hd-live-map-to-show-the-path-tohighly-automated-driving/

[41] P. F. Alcantarilla, S. Stent, G. Ros, R. Arroyo, and R. Gherardi, “Street-view change detection with deconvolutional networks,” Auto. Robots, vol. 42, no. 7, pp. 1301–1322, Oct. 2018.

[42] H. G. Seif and X. Hu, “Autonomous driving in the iCity—HD maps as a key challenge of the automotive industry,” Engineering, vol. 2, no. 2, pp. 159–162, Jun. 2016.

[43] J. Jiao, “Machine learning assisted high-definition map creation,” in Proc. IEEE 42nd Annu. Comput. Softw. Appl. Conf. (COMPSAC), Tokyo, Japan,Jul. 2018, pp. 367–373.

[44] J. J. Leonard and H. F. Durrant-Whyte, “Simultaneous map building and localization for an autonomous mobile robot,” in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Nov. 1991, pp. 1442–1447.

[45] H. Durrant-Whyte and T. Bailey, “Simultaneous localization and mapping: Part I,” IEEE Robot. Autom. Mag., vol. 13, no. 2, pp. 99–110, Jun. 2006.

[46] C. Cadena et al., “Past, present, and future of simultaneous localization and mapping: Toward the robust-perception age,” IEEE Trans. Robot., vol. 32, no. 6, pp. 1309–1332, Dec. 2016.

[47] G. Bresson, Z. Alsayed, L. Yu, and S. Glaser, “Simultaneous localization and mapping: A survey of current trends in autonomous driving,” IEEE Trans. Intell. Veh., vol. 2, no. 3, pp. 194–220, Sep. 2017.

[48] C. Urmson et al., “Tartan racing: A multi-modal approach to the DARPA urban challenge,” Carnegie Mellon Univ., Pittsburgh, PA, USA, Tech. Rep., Apr. 2007.

[49] L. Riazuelo, J. Civera, and J. M. M. Montiel, “C2TAM: A cloud framework for cooperative tracking and mapping,” Robot. Auto. Syst., vol. 62, no. 4, pp. 401–413, 2014.