多种基于卷积神经网络的语义分割模型-姚卫博士

2021-12-30

图像分割基本上可以分为两种类型:语义分割和实例分割。近些年,基于CNN的语义和实例分割的研究得到了大量的关注。以下将详细探讨一些先进的基于CNN的语义分割模型的体系结构细节[1]。模型是根据使用的最重要的特征进行分类的。在每一个分类讨论的最后,还简要讨论了特定模型类别的优点和缺点。

1. 基于完全卷积网络

Long等人提出了完全卷积网络(FCN)来解决语义分割问题[2]。他们使用了AlexNet、VGGNet和GoogleNe(这三个都是在ILSVRC数据上预先训练过的)作为基本模型。他们将这些模型从classifiers转变为稠密的FCN,方法是用1×1卷积层代替完全连接层,并附加一个通道数为21的1×1卷积来预测20个PASCAL VOC类和1个背景类的得分。

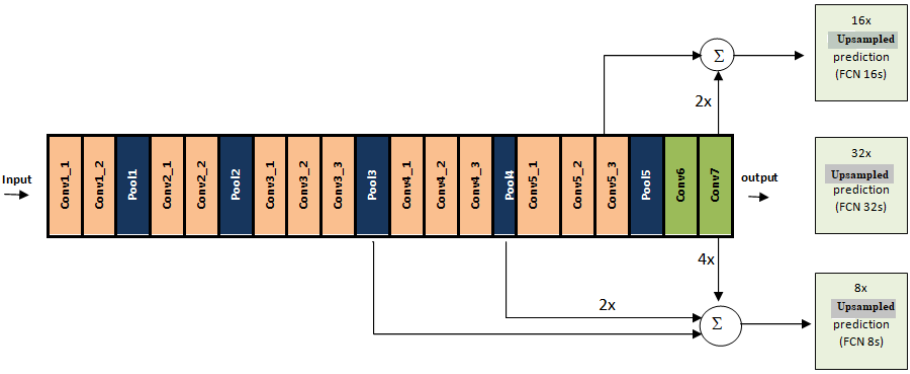

在FCN AlexNet、FCN-VGG16和FCN GoogLeNet中,FCN-VGG16在PASCAL VOC 2011验证数据集上的准确度最高。因此,作者选择FCN-VGG16网络进行进一步的实验。由于网络生成了粗糙的输出位置,作者使用双线性插值对粗输出32×进行上采样,使其像素密集。但是这种上采样对于详细的分割是不够的。因此,他们使用跳跃连接来组合预测层和VGG16丰富的下层特征,并将这种组合称为deep jet。图1显示了不同的deep jet:FCN-16s、FCN-8s和FCN-32s。其中FCN-8s在PASCAL VOC 2011中的表现最好。

图1. FCN32s, FCN16s, FCN8s的结构

FCN的主要变化有:基本模型VGG16、双极插值技术(用于对原始特征图进行上采样)和跳过连接(用于将低层和高层特征结合起来以进行细粒度语义分割),这些都有助于该模型达到最新的结果。

FCN只利用局部信息进行语义分割,但由于局部信息会使图像的全局语义上下文变得模糊。从整个图像中减少模糊的上下文信息是很有帮助的。

2. 基于Dialatation卷积

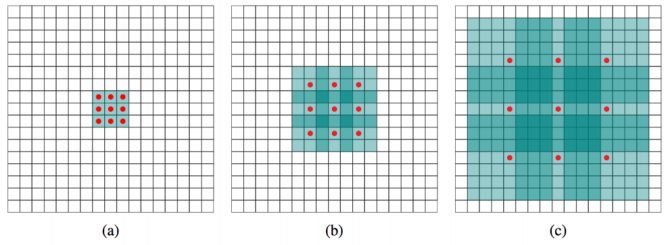

Dialated-Net:传统的CNN用于分类任务,会损失分辨率,不适合密集预测。Yu和Koltun引入了传统CNN的改进版本,称为dialated卷积或Dialated-Net[3],系统地积累多尺度上下文信息,以便在不损失分辨率的情况下更好地进行分割。Dialated-Net就像一个卷积层的矩形棱镜,不像传统的金字塔CNN。如图2所示,在不丢失任何空间信息的情况下,它可以支持指数扩展的感知域。

图2. (a) 1倍dialation,感知域3×3;(b) 2倍dialation,感知域7×7;(c) 4倍dialation,感知域15×15

基于dialation模型的优点是它有助于保持图像的空间分辨率以产生密集的预测。但是,使用dialation卷积将图像像素从其全局上下文中分离出来,这使得它很容易被误分类。

3. 基于自上而下/自下而上的方法

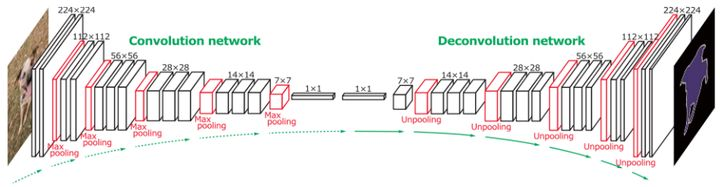

DeconvNet由Noh等人提出[4],具有卷积和反卷积网络。卷积网络在拓扑上与VGG16的前13个卷积层和2个完全连接层相同,除了最后的分类层。反卷积网络与卷积网络相同,但层次相反。同时,它还具有多个系列的反卷积层、反池化层和反整流层。卷积和反卷积网络的所有层都提取特征映射,除了反卷积网络的最后一层是用于生成像素级的概率图,它与输入图像的尺寸相同。在反卷积网络中,作者应用了反池化操作来重建初始激活大小。此处,反池化操作是通过在卷积操作时存储的最大池索引来完成的。为了使放大但稀疏的反池化特征图的密度更大,作者将单个输入激活与多个输出相关联,使用多个习得的滤波器完成类似卷积的操作。与FCN不同,作者将他们的网络应用于从输入图像中提取出的目标建议,并产生像素级预测。然后,将所有建议的输出集合到原始图像空间,对整个图像进行分割。这种基于实例的分割方法能够处理多尺度对象的细节,同时降低了训练的复杂度和训练的内存消耗。为了处理网络中的内部协变量偏移,作者在卷积层和反卷积层之上添加了批处理规范化层。DevNet的架构如图3所示。

图3. DeconvNet的网络结构

由于基于FCN的模型在最后层的上采样率很高,所以会产生粗输出。因此,不可能进行精细的语义分割。另一方面,基于自上而下/自下而上方法的模型使用逐渐增加的上采样率,从而获得更精确的分割。但在这种情况下,该模型还缺少全局上下文信息的整合。

4. 基于全局语境的方法

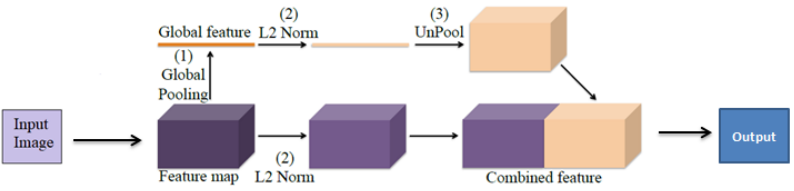

ParseNet:Liu等人提出了一种端到端结构的ParseNet[5],它是对全卷积神经网络的改进。为了更好的分割,作者添加了全局特征或全局上下文信息。图4显示了ParseNet的模型描述。在提取卷积特征映射之前,ParseNet与FCN相同。之后,作者使用了全局平均池化来提取全局上下文信息。然后,对池化后的特征图进行反池化操作,使其与输入特征图的大小相同。现在,将原始特征图和反池化后的特征图结合起来预测分类。作者将两个不同的特征图组合在一起,而这些特征图在规模和标准上都是不同的。为了使这种组合起作用,他们使用了两个L2规范化层:一个是在全局池化层之后,另一个是在从FCN中提取原始特征图之后。该网络在ShiftFlow,PASCAL context上达到了最先进的性能,在PASCAL VOC 2012数据集上接近最新水平。

图4. ParseNet的模型设计

虽然全局卷积的应用有助于提高精度,但它缺乏多尺度目标的尺度信息。

5. 基于感受野放大的方法

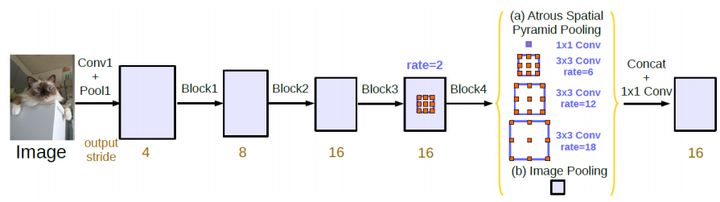

DeepLabv2和DeepLabV3:DeepLabv2[6]和DeepLabV3[7]的作者使用Atrous Special Pooling Pyramid(ASPP)修改了他们的网络,聚集多尺度的特征以更好地进行定位,并提出了DeepLabv2。图5显示了ASPP。该体系结构同时使用ResNet和VGGNet作为基础网络。在DeepLabv3中,为了将多个语境合并到网络中,作者使用了级联模块,并对ASPP模块进行了深入研究。

图5. Atrous Spatial Pooling Pyramid

利用基于多分辨率金字塔的表示方法可以扩大感受野,这有助于上述模型融合对象的尺度信息,获得精细的语义分割。但是,为了获得更好的语义分割,使用感受野扩大来捕获语境信息可能不是唯一的解决方案。

参考文献

[1] F. Sultana, A. Sufian, P. Dutta, Evolution of Image Segmentation using Deep Convolutional Neural Network: A Survey, Knowledge-Based Systems, 201-202(2020) 106062.

[2] E. Shelhamer, J. Long, T. Darrell, Fully convolutional networks for semantic segmentation, IEEE Trans. Pattern Anal. Mach. Intell. 39 (4) (2017) 640–651.

[3] F. Yu, V. Koltun, Multi-scale context aggregation by dilated convolutions, in: 4th International Conference on Learning Representations, ICLR, 2016, San Juan, Puerto Rico, May 2-4, 2016, Conference Track Proceedings.

[4] H. Noh, S. Hong, B. Han, Learning deconvolution network for semantic segmentation, in: Proceedings of the IEEE International Conference on Computer Vision, 2015, pp. 1520–1528.

[5] W. Liu, A. Rabinovich, A.C. Berg, Parsenet: Looking wider to see better, 2015, CoRR abs/1506.04579, arXiv:1506.04579.

[6] L. Chen, G. Papandreou, I. Kokkinos, K. Murphy, A.L. Yuille, Deeplab: Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs, 2016, CoRR abs/1606.00915, arXiv: 1606.00915.

[7] L. Chen, G. Papandreou, F. Schroff, H. Adam, Rethinking atrous convolution for semantic image segmentation, 2017, CoRR abs/1706.05587 arXiv: 1706.05587.