基于神经网络的医学图像融合技术-姚卫博士

2021-10-13

为提高医学图像信息的利用率以及增强单模态下的医学图像信息准确性,通常可采集人体组织或器官在不同模态下的医学影像,然后选择合适的算法或网络结构,利用图像融合技术,将各个单模态下的医学图像包含的有效信息尽可能融合在一起,最终生成一张信息量丰富的融合图像。近年来,医学图像融合技术逐渐发展成为医学图像处理的一个研究热点[1]。一般情况下,图像融合需要遵循三个原则[2]:第一,融合后的图像不能丢失原有图片中重要特征点信息;第二,融合后的图像只能有原图片本身与设备影响的信息;第三,融合后的图像尽可能去掉原图片中无效信息或影响融合质量的干扰信息。

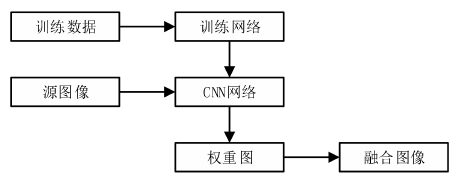

最近十多年,随着深度学习的发展,基于深度学习的图像融合技术取得了重大进展。在医学图像融合领域,相比传统算法融合技术,基于深度学习的图像融合技术在特征提取、图片识别等均表现出优势。深度学习模型可以表征医学图像,处理弯曲形状和高质量的细节信息。深度学习强大的特征学习能力在医学图像融合的特征提取中有利于融合效果。融合权重通常由不同图片间部分视觉特征的空间改变推导产生,如像素方差、颜色饱和度和对比度等特征,根据不同图像特征来适应图像中不同位置的内容,并对其进行优先级排序[3]。分解后的图像的特征以及像素的权重分配将会影响到融合结果。Liu 等[4]通过卷积神经网络(CNN)网络参数的学习,以最合适的方式获取和分配最优权值。基于CNN图像融合的过程如图1所示,CNN网络可以利用原图片生成权值图,输出神经元均为归一化权重分配的结果。

图 1 基于CNN的图像融合过程

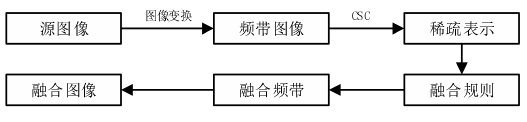

医学图像融合过程中的第一步是多尺度变换,变换后的结果对后续的特征提取与融合规则的制定有着重要的影响。因此,通过深度学习获得一个合适的变换是医学图像融合过程中的关键点。针对CNN输出维度低导致信息丢失,利用基于Hek的方法初始化第一层以外的卷积核,第一层是由高斯拉普拉斯滤波器与Gaussian滤波器解析的子图像组成的,通过一个高频分量与一个低频分量,在融合过程中自适应分解和重建图像。基于稀疏表示的SR融合方法[5]存在细节特征信息的保留能力有限和位置偏差敏感两个劣势。因此,Liu等[6]提出了基于CSR的图像融合方法,将原图片解析为基础层与细节层进行多模态的融合,结果表明融合效果明显优于原先的图像融合方法。图2为基于CSR的图像融合过程。首先,对源图像执行特定图像变换。然后,通过一组离线学习字典过滤器对选定的变换频带执行CSC。根据具体的融合问题选取不同的图像变换和融合方式,使其在学习阶段,生成训练样本和设置相关学习参数均可以影响最终的融合效果。

图2 基于CSR的图像融合过程

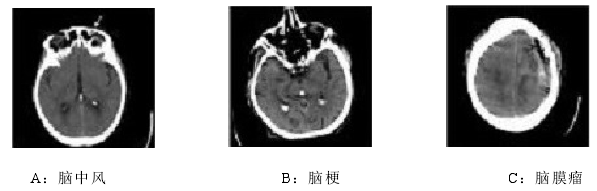

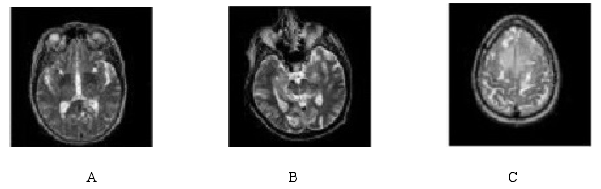

文献[7]搭建了基于拉普拉斯金字塔结合卷积神经网络(LPCNN)的医学图像融合算法。为提高融合性能,利用拉普拉斯金字塔分解源图像,引用支持向量机思想对CNN网络进行改进,使其不依赖于经验初始化参数,有效提取图像特征生成最优权重图W,通过将CNN网络的池化层、采样层去除来降低图像信息的损失。文献[7]从哈佛医学院全脑图的数据集中选取部分脑部疾病的CT与MR图,结合两者图像自身特点,使融合后信息量更足,相关特征更显著,临床诊断的依据更精确。CT图显示为灰度图,利用明暗程度存在差异的灰度表示横断层面中人体组织与器官,灰度越暗说明人体组织或器官对射线的汲取程度越低,灰度越亮说明对射线的汲取程度越高,主要集中在密度相对高的骨骼等部位。MR(Magnetic Resonance)为磁共振成像技术,其原理是利用磁场与人体作用来产生共振的方式来获得电磁信号,将人体信息构建到医学影像上。图3-4是部分脑部疾病的CT与MR图,图5是文献[7]中对图3和图4进行融合后的结果。

图3 三组脑部疾病CT图

图4 三组脑部疾病MR图

图5 文献[7]中算法的融合效果图

实验结果表明,文献[7]中算法的融合结果较好,图像清晰度较高,对MR源图像中软组织的信息保护程度上突出,融合效果较好。

[1] Kai-jian Xia, Hong-sheng Yin, Jiang-qiang Wang. A novel improved deep convolutional neural network model for medical image fusion[J]. Cluster Computing, 2019,22(1):1515-1527.

[2] Haithem Hermessi, Olfa Mourali, Ezzeddine Zagrouba. Convolutional neural network-based multimodal image fusion via similarity learning in the shearlet domain[J]. Neural Computing and Applications, 2018,30(7):2029-2045.

[3] 薛湛琦, 王远军. 基于深度学习的多模态医学图像融合方法研究进展[J].中国医学物理学杂志, 2020,37(05):579-583.

[4] LIU Y, CHEN X, PENG H, et al. Multiple-focus image fusion with a deep convolutional neural network[J]. Inf Fusion, 2017,36(4):191-207.

[5] 王丽芳, 董侠, 秦品乐, 高媛. 基于自适应联合字典学习的脑部多模态图像融合方法[J]. 计算机应用, 2018,38(04):1134-1140.

[6] LIU Y, CHEN X, WARD R K, et al. Image fusion with convolutional sparse representation[J]. IEEE Signal Process Lett, 2016,23(12):1882-1886.

[7] 姚徐. 基于深度卷积神经网络的医学图像融合算法研究[D].哈尔滨理工大学,2021.