全息近眼显示的沉浸式体验-李维娜博士

2021-04-07

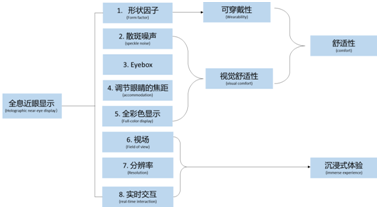

全息近眼显示(holographic near-eye display)是AR/VR的发展趋势,从用户的角度来讲,极致的体验包含舒适性(comfort)和沉浸式体验(immersion)两个方面,如图1所示。舒适性与可穿戴性(wearability),视觉舒适性相关,这两项又包含了五个小方面:形状因子,视窗(eyebox)大小,光斑噪声,调节眼睛的焦距,和全彩色显示。而沉浸式体验与视场,显示的分辨率,以及实时交互有关。前两篇文章我们介绍了形状因子,散斑噪声,视窗(eyebox),调节眼睛的焦距(accommodation)和全彩色显示(full-color display)。这篇文章我们主要介绍沉浸式体验的视场,分辨率以及实时交互这三方面的要求。

图1. 以人为中心的视角分类全息近眼显示。

1. 视场(FOV:Field of View)

物体跨越的距离或角度的范围被定义为视场。在全息显示里,加载了菲涅尔全息图或者傅里叶全息图的空间光调节器(SLM:spatial light modulator)通常被放置在显示系统的出瞳,所以SLM的最大的衍射角决定了全息图像的最大尺寸和系统的视场。假设给定SLM的像素尺寸p和入射光的锥形角,则可由【1】计算得出,其表达式如Eq.(1)所示。

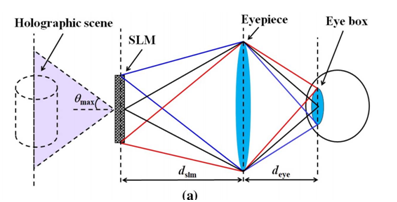

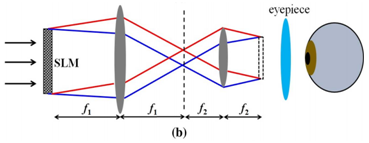

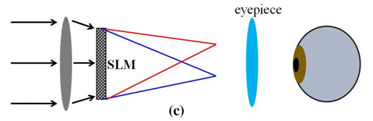

为了佩戴舒适而制造的出瞳距离,一个典型的显示通常用目镜把SLM上的波前中继到眼睛的瞳孔,如图2(a)所示。假设SLM和目镜之间的距离dslm时给定的,出瞳距离deye可表示为 ,其中f是目镜的焦距。FOV可以被当作通过目镜的中继SLM的衍射角来计算:

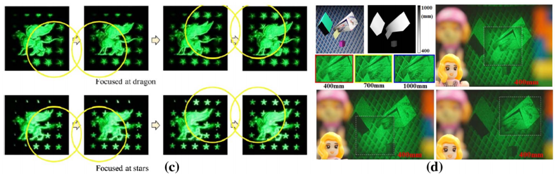

典型的SLM的像素尺寸的范围是3µm~12µm。因此,在平面波的照射下衍射角 一般小于5°。为了扩展FOV,在给定SLM的情况下,我们可以采用两个策略来增大衍射角:瞳孔终继和球面波照射【2】。第一个策略利用一个4f中继系统缩小SLM【图2(b)】,成像的像素变得更小从而产生较大的衍射角 ,因此产生一个较大的FOV。第二个策略利用一个球面波照射SLM【图2(c)】【3】,增大了衍射角 和FOV. 在另一个应用里,Su 等利用一个离轴的全息透镜来替代球面波照射,在SLM之后引进了一个二次的波前调制【4】。

图2.全息近眼显示的FOV。(a)增加了一个目镜的全息近眼显示,(b)通过瞳孔中继扩大FOV,(c)通过球面波扩大FOV。

尽管以上两种策略的实现都很简单,但都是因为有限的空间带宽积牺牲了视窗的大小。为了缓解这种折衷关系,我们可以在平面的或者曲面的装置里利用多个SLM【5-11】。然而这个方法因为体积的关系却不易被应用在近场显示里。有一个更加实用的方法是利用像素尺寸被缩小的SLM,所以在同等大小的区域里就会有更多的像素数。因为制造工艺的限制,在基于L-cos或者DMD的SLM上进一步地降低像素尺寸的大小是非常有挑战性的【12-14】。相反,介电超表面在这方面很有前景,它能把CGH的像素尺寸在亚波长的量级(~300nm)内编码,所以使FOV(~60°)比目前系统的FOV大很多。而且,超表面全息图能在像素级别控制光的偏振状态【15】,在增加空间带宽积方面有更多的自由度。作为一个新颖的技术,介电超表面全息术仍然面对很多挑战,比如缺少纳米量级的矢量衍射的算法,高成本和耗时的制备过程,以及不能动态地调制波前。

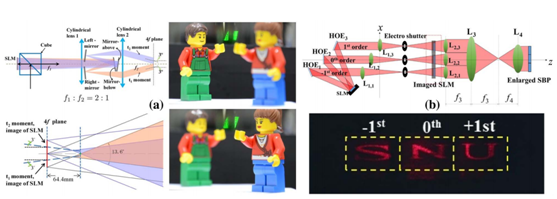

时间复用是一个可替代的解决方法,它以降低帧率为代价增大FOV。图3(a)展示了一个具有代表性的时间分异和空间拼接(TDST:temporal division and spatial tiling)的系统【1】。空间分开衍射的两个CGH按顺序显示在SLM上。然后把输出的图像在曲面上拼接增大了FOV。【16,17】提出了一个相似的利用了共振扫描的方法。图3(b)展示了另一个时间复用的实验装置,它利用了SLM的高阶衍射【18】。Li 等在水平方向上把SLM的不同级别的衍射拼接起来,并且通过一个同步的电子快门一次传递一个特殊的级别。并且论证了水平方向的FOV可被提高三倍。

图3. 扩大FOV通过 (a) 时间分异和空间拼接,(b)时间分异和衍射级拼接。

B. 分辨率和注视点渲染

目前大多数商业的近眼显示提供了一个10~15像素/度(ppd)的角分辨率,所以一个正常成人的视力(视敏度)大约是60ppd。像素化的图像会阻碍沉浸式体验。为了提高中央视觉的分辨率(~±5°)开发了注视点显示技术,而只用几个像素渲染了周边区域。当与眼睛追踪(eye tracking)相结合时,注视点显示能提供一个很大的FOV,且具有一个增加了感知的分辨率。普遍的实现方式是用多个显示面板创造分辨率变化的图像【19,20】。视网膜中凹和周边区域可以用巡微显示(traveling micro-display)和HOE动态地被视线驱动【21】。

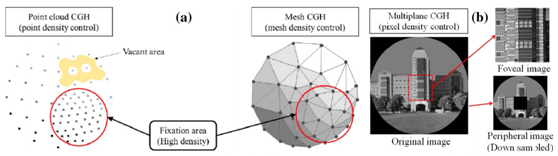

在全息近眼显示里,注视图像渲染(foveated image rendering)已经被主要用来降低计算量【22-27】。图4(a)和(b)展示说明了利用注视显示从点云生成CGH的例子【22-24】,从多边形网格(polygon- mesh)生成CGH的例子【25】,以及从基于从平面模型生成CGH的例子【27】。所有这些实现方式都只为视网膜中央凹的区域渲染了一个高分辨率的图像,而降低了周边区域的分辨率,因此显著地减少了计算CGH所需要的时间。为了渲染一个跟随视线角度的中央凹图像,我们必须相应地更新CGH。对于多边形网格【25】和基于多平面的模型【27】,图4(c)和(d)分别显示了当视线落在不同位置时图像分辨率不同。

图4. 注视点图像渲染,来源于(a)点云和基于多边形的模型,和(b)基于多平面的模型。视网膜中央凹的内容随视线的角度而改变,来源于(c)基于多边形的模型,和(d)基于多平面的模型。

3 实时交互(Real-Time Interaction)

a. 手势和触觉的交互

为了提高沉浸式体验人机交互是必不可少的。当用户在显示环境中体验虚拟物体时VR系统已经广泛应用了手势或者触觉的反馈,这些反馈提供了更逼真的感觉来模仿物理交互的过程【28】。然而触觉技术依赖于可穿戴设备,比如触觉手套,手势通过手和手指的移动更加交互地处理现实世界的虚拟物体,可以被动作传感器探测。Yamada等提出了一项最新的交互型的桌上型全息显示【29】。他们利用CGH显示全息3D图像,利用动作传感器(Leap Motion Inc.)准确地探测手和手指的手势。然而,全息近眼显示已经在探索具有手势交互的实时CGH显示。

b. 实时CGH的计算

在目前的全息近眼显示里,由于需要处理巨大的数据CGH经常在线下计算。对于实时交互,快速CGH是关键的,可以通过快速算法和提高硬件来达到。为了计算CGH,我们通常利用基于点云,多边形,光线和多平面的模型的算法。在点云模型里,3D物体被渲染成大量的点源。相应的CGH可以利用lookup table(LUT)【30-32】和波前记录平面(WRP)的方法来加速【33】。然而,依然需要大量存储和高速的数据传输率。多边形模型把3D物体描述为大量小平面多边形的集合【34】。 它通过降低采样率和快速傅里叶变换(FFT)比点云模型更快【35,36】。然而,重建像却有条纹噪声【37】。 基于光线模型在CGH计算中比点云模型和多边形模型更快【38,39】。 然而,在光场的获取和渲染会增加额外的计算开销。迄今为止,多平面模型是被认为是实时交互全息近眼显示的最好的模型,它在平面间只包含了有限的FFT,因此提供了最快速的CGH计算【40】。值得注意的是,最近的一项研究显示机器学习方向的探索能在多平面模型上更进一步提高CGH的计算速度,能实时生成具有1080p分辨率的全彩色全息图【41】。另一方面,硬件的进展也能提高CGH的计算速度【42】,比如现场可编程门阵列(FPGA)和图形处理单元(GPU)的配置。最近一个基于FPGA的强大的被命名为“HORN”计算机被开发用于CGH的快速计算【43-45】。HORN在执行CGH算法比个人电脑快几千倍。比如,它能仅在0.77s内从1024个渲染的多平面图像计算 分辨率的全息图【46】。基于FPGA方法的实际应用被长时间FPGA电路设计的研发周期所阻碍。GPU可用于同样的目的。比如,NVIDIA Geforce系列的 GPU能在55ms内从2048个点的3D物体计算得到一个大小为 的CGH【47】。 在另一个例子里,Gilles等利用基于层的CGH算法论证了大小为 的CGH可以被实时(24fps)地计算【48】。在全息显示里我们期望表现更优异的GPU将胜任实时交互的计算工作。虽然我们这里只讨论线下的计算,实时线上处理也可能被新颖的算法和硬件协和整同所实现。