5G网络助力XR(四)-@面向无线XR的组播(multicast)-杨军超博士

2021-03-19

1. 引言

VR视频高分辨、高帧率的特点使得其对网络带宽要求高,在目前网络资源有限的情况下,VR视频传输相当具有挑战性。另外,传统视频观看时屏幕往往可以共享,例如一家人观看电视或者在电影院观看电影。然而HMD的屏幕却不能共享,在同一个地方请求同一内容的VR用户则需要分别传输视频内容,这无疑也增加了网络带宽的压力。此外,由于用户HMD的FoV限制,360度的VR视频仅有一部分被用户观看,而其他部分仍需要传输给用户,无疑这部分内容的传输造成了很大的带宽资源浪费。因此,高效的传输高质量的VR视频是目前VR应用面临的一个最关键的挑战。

在VR的初始阶段,大部分的VR视频都是预先下载到用户终端,然后用户通过移动FoV在本地观看VR内容[1]。最近,越来越多的用户希望可以随时随地的通过装配有图形处理单元(graphics processing unit, GPU)的便携式HMD进行VR体验,也称为移动VR(mobile VR)[2]。为了应对VR视频无线传输的挑战,文献[3]提出了一个面向移动网络的VR视频传输机制,即基于用户头部运动估计,仅传输用户要观看的视频部分。然而这种方法过度依赖于用户视点的预测,一旦传输的数据与用户真实的FoV不匹配,则会造成用户体验明显下降。此外,为了使传输的内容能与用户频繁变化的视点保持同步,视频块的长度也要保持相对较小[4],由此引起的低效的压缩和数据同步开销也会导致传输效率降低。为了减少传输带宽消耗,基于Tile的自适应传输被广泛研究,然而此类方法通常基于单播的方式将VR视频传输给各用户,虽然Tile的机制能减少部分带宽消耗,但是将一个VR视频以单播的方式传输给上千甚至上万的用户并不是一个高效的方案。最近,有一部分研究者尝试着采用组播的方式传输给同时观看同一VR视频内容的用户,基于视点预测仅传输部分的VR视频,而这部分VR视频通过组播或者单播的形式进行传输[5]。为了提升组播的频谱效率,文献[6]提出了一种多会话(multi-session)的组播传输机制,其中,用户分组、无线资源分配以及Tile的码率选择进行了联合优化。基于同样的动机,文献[7]提出了一种基于DASH的组播的机制,其中,组播的会话传输以Tile为粒度,即每一个Tile均选择合适的一个版本或者多个版本进行组播传输,并提出了一种启发式的Tile码率选择的算法。

移动VR被认为是未来5G的“杀手级”应用,异构云接入网作为5G的典型架构,在大带宽、低延迟的应用中已经展示出了巨大的潜力。H-CRAN将大规模的微基站部署与云接入网融合到一个网络架构中,提升了频谱效率以及资源管理效率。注意到组播的传输方式很大程度上提升了传输效率,然而用户QoE将会降低,与之相反的,单播的传输方式一定程度上能保障用户的QoE,但传输效率则较低,尤其是在多用户同时请求同一内容的场景时。

2. 基于视点预测的组播协同VR传输策略

基于[9]的启发,考虑到VR用户的QoE和传输效率的折中,我们探索了H-CRAN中利用组播与单播协同的传输方式。具体地讲,一个基础版本的全景视频通过宏基站以组播的形式传输给所有用户,与此同时,基于用户视点预测,各用户视点部分通过微基站以单播的形式分别传输增强版本的Tile。此外,利用移动边缘计算(mobile-edge computing, MEC)进行提前内容缓存和实时转码,将内容推到更接近用户终端的MEC服务器,进而降低端到端的延迟。为了同时保证H-CRAN中VR用户的QoE和传输效率,提出了基于视点预测的组播与单播协同(cooperative multicast and unicast with viewport prediction, CMU-VP)的VR视频传输机制。

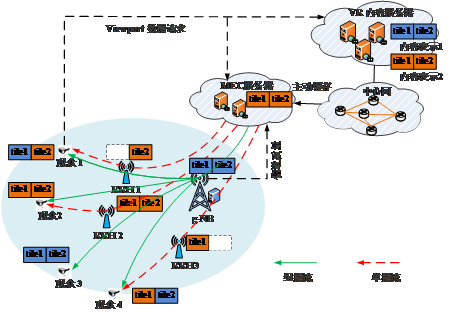

系统模型具体如图1所示,主要包括三大部分:VR内容服务器、移动边缘计算(mobile-edge computing, MEC)服务器以及H-CRAN。系统具体描述如下:

VR内容服务器主要负责存储压缩编码后的VR视频。基于Tile的压缩编码,VR视频在空间上分割成可独立解码的Tile,其中Tile的索引表示为 ,各Tile均生成多个版本的码率,表示为 ,其中 和 分别表示第t个Tile最小和最大的压缩码率。各Tile码流在时间粒度上被分割成块(Chunk)。此外,用户视点预测模块集成在内容服务器,其利用用户间运动相似度和用户历史运动轨迹进行视点预测,预测的结果反馈给MEC服务器用于组播与单播协同传输的调度。

图1 5G场景下VR确定时延的缓存管理策略

移动边缘计算服务器位于H-CRAN的边缘,其能够进行提前的VR内容缓存和实时的转码[10]。当位于H-CRAN范围内的用户终端请求VR视频内容时,请求的数据将从移动边缘计算服务器返回。为了给组播与单播协同传输提供合适的Tile版本,一个实时的转码模块基于缓存的VR视频,组播的视频和单播的增强版本的Tile均基于优化的组播与单播协同传输的调度结果选择合适的量化参数(quantization parameters, QPs)进行转码[11],然后分别进行组播与单播的传输。

系统采用软件定义网络技术,支持控制信息与数据分离,即控制信息通过g-NB宏基站传输,数据通过远端射频单元传输。g-NB宏基站主要负责控制信息传输和组播业务。考虑V个用户同时请求VR视频。所有用户终端均支持双连接。用户终端周期性通过上行参考信号广播各链路信噪比(signal interference to noise ratio, SINR)。移动边缘计算服务器,基于链路信道质量和预测的用户视点,进行组播与单播调度优化,其优化的结果反馈到用户终端,用户终端基于优化结果请求合适的视频码率。最终移动边缘计算服务器执行相应的转码,并将合适码率的Tile块分别分发到宏基站和微基站。

利用H-CRAN中用户终端双连接的特征,结合单播在提升用户体验以及组播在传输效率的优势,提出了一种基于视点预测的组播与单播协同的VR视频传输机制,旨在兼顾传输效率与用户体验。一个基础版本的全景视频通过宏基站以组播的形式传输给所有用户,与此同时,基于用户视点预测,各用户视点范围的内容通过微基站以单播的形式分别传输增强版本的Tile。用户终端在接收到组播与单播的数据之后,将它们融合成一个新版本的VR视频块。

1) 基于Tile编码的VR视频预先缓存在移动边缘计算服务器上,考虑到移动边缘计算服务器的存储限制,VR视频各Tile仅最大码率的版本被缓存。当在H-CRAN范围内的用户请求视频内容时,请求的数据将从移动边缘计算服务器返回。

2) 一旦VR内容服务器收到用户请求VR视频的请求,它首先在负责组播会话管理的广播服务中心创建一个组播服务,另外,它与每一个用户终端维持一个用于传输视点部分质量增强Tile的单播会话。

3) 与此同时,在VR内容服务器,基于用户视点的历史运动轨迹进行用户视点预测,预测的结果将即时反馈给移动边缘计算服务器,用于组播与单播协同传输的调度。

4) 在移动边缘计算服务器,组播与单播协同传输的调度优化将综合考虑各Tile的被各用户观看的概率以及组播与单播的信道质量,基于优化的结果,一个用于组播的基础版本的全景视频和相应各用户预测视点范围的质量增强的Tile将通过实时的转码模块产生。

5) 基于SDN技术,基础版本的全景视频和视点范围的质量增强的Tile将分别分发到宏基站和微基站进行组播与单播传输。

6) 基于双连接技术的支持,用户终端将分别收到来自宏基站的组播传输的基础版本的全景视频数据以及来自其关联的微基站单播传输的视点范围的质量增强的Tile数据。接收的组播数据与单播数据在用户缓存中进行融合,即同时接收到组播与单播数据的Tile块,低码率版本将被丢弃。

3. 结束语

单播的形式传输VR视频在一定程度上能够保证用户体验,但由于VR应用屏幕无法共享的特性,造成单播的形式对带宽资源的消耗较高,其传输效率较低。相对应的,组播的传输形式能够很大程度上提升带宽资源的利用效率,但对于各个用户视点的不同需求则无法一一满足。基于H-CRAN中网络异构以及双连接技术,我们提出了一种基于组播与单播协同的VR视频传输机制,旨在解决VR视频传输过程中传输效率与用户体验无法兼顾的难题。